Hippo's data

생성형 AI 사피엔스 본문

오늘은 생성형 AI 사피엔스라는 책에 대해 리뷰해 보겠다

하하하

리뷰라기엔 거창하지만 그냥 읽고 난 후 느낌? 생각들?을 써보려 한다

책을 진짜 오랜만에 읽는다

이번 학기에 휴학하고 프로젝트를 진행하면서 너무 바쁘게 달려왔다

드디어 프로젝트가 거의 끝나고 이럴 때 아니면 언제 읽겠냐... 라는 생각에 책을 읽어보았따

이 책은 생성형 AI에 대한 기술적인 측면에 대한 내용이라기 보다는

어떻게 활용되며 쓰이고 있고 전망에 대해 소개하는 책이다.

휴학하고 인공지능 관련 프로젝트를 진행하면서 '생성형 AI'라는 단어에 대해 많이 들어봤지만

무엇을 의미하는지 정확히 모르고 있었다

특히 이 책의 부제는 ' 챗GPT가 앞당긴 인류의 미래'인데 프로젝트 중에 Chat GPT 유료결제까지 하며 정말 많은 부분에서 의존했던 나로써는 이 책을 보고 그냥 넘어갈 수 없었따

생성형 AI(Generative AI)란 무엇일까?

말 그래도 무언가를 만들어내는 AI를 말한다

즉, 이미지나 오디오, 텍스트 등 기존의 콘텐츠들을 활용하여 새로운 콘텐츠를 만들어내는 것이다

요즘 핫한 Open AI에서 서비스 하는 Chat GPT도 이에 해당하며 이미지를 생성해주는 달리(DALL·E)도 이에 해당한다

Chat GPT의 기술적 측면에 대해서도 간략이 소개한다

Chat GPT는 자연어처리(NLP)기술의 한 측면으로 바라볼 수 있다

초기 자연어 처리 기술은 문법적인 접근을 통해 분석을 진행하려 했으나 사람의 언어가 완벽히 문법에 맞지 않고 꾸준히 새롭게 등장하는 단어로 인해 이러한 접근법은 한계를 봉착했다

이후 언어모델(Language Model)이 라는 새로은 방법론이 등장했고 이 기술이 Chat GPT에 사용되게 된다

언어모델(Language Model)을 만드는 방법에 대해서도 간단히 소개하는데

1. 다음 단어 맞추기 - 1박(2일) / 무한(도전) 처럼 특정 단어 이후 등장할 단어에 대해 확률적으로 예측한다

2. 빈칸 채우기 - 동해믈과 (백두산이) 마르고 닳도록 처럼 앞뒤 단어의 가중치를 학습하여 빈칸에 올 단어를 예측한다

언어모델은 다다익선이라고 많은 문장을 학습할 수록 좋은 정확도가 나오는 것은 자명한 사실이다

하지만 현실적으로 데이터 수집, 학습에 천문학적인 비용이 사용되며 '타협'하는게 필요하다

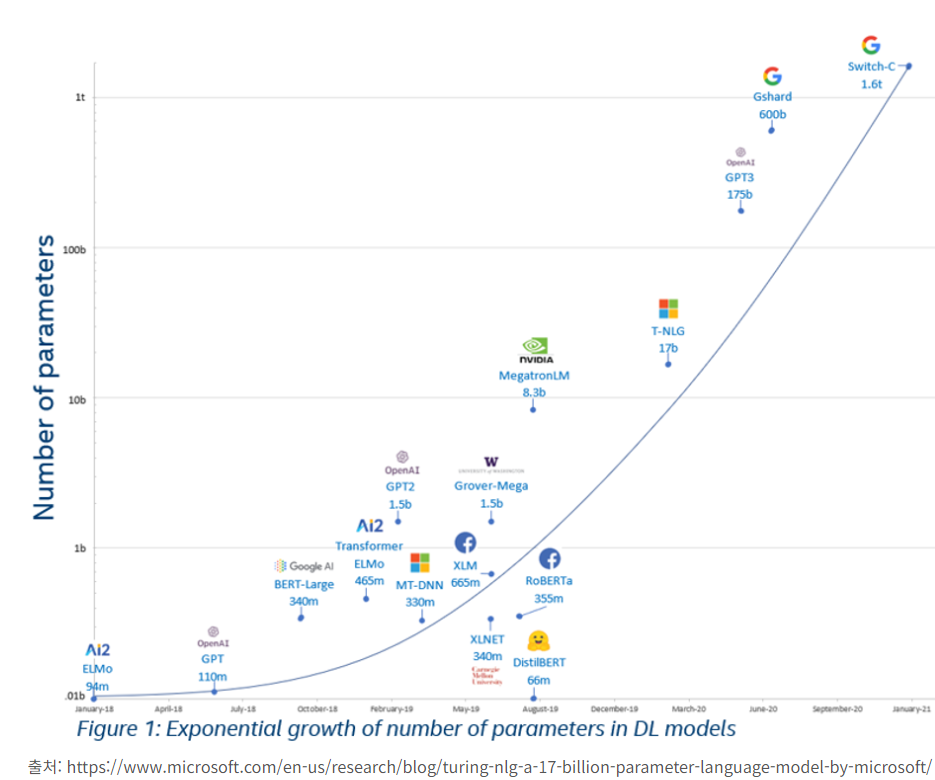

모델이 얼마나 많은 자료를 통해 학습했는지 즉. 모델의 복잡성은 파라미터(Parameter)의 수로 측정하는데

위 그래프는 다양한 언어모델들의 파라미터 수를 표현한 그래프이다

이를 통해 바라보면 파라미터의 수가 빠른 추세로 증가하고 있음을 알수 있는데 진짜 곧 거대거대거대언어 모델이라는 무시무시한 친구가 등장하는 것이 아닐지 기대되기도 한다

이 책에서는 다양한 생성형 AI 서비스에 대해 소개하고 있는데

그중 가장 와닿은 내용은 프로그래밍 분야의 생성형 AI 서비스이었다

프로젝트를 진행하면서 쥐피티의 도움을 많이 받았는데 그냥 챗쥐피티에 코드를 던지면 오류도 찾아주고 심지어 해당 코드가 어떻게 동작하는지 알려주고 주석까지 달아준다..... 진짜 쥐피티 없이는 못사는 세상이 되어버린걸까

이에 챗쥐피티가 아닌 copilot, Deepcode 같은 전문적으로 프로그래밍에 도움을 주는 서비스를 소개하는데 얼마나 기똥차게 도움을 받을까 한번 써봐야겠따

진짜 개발자라는 전문적인 코드를 짜는 직업이 사라지고 도메인적 지식 기반이 메인이고 전문적인 프로그래밍적인 지식 없이 다양한 툴을 통해 코드작성에 도움을 받는 그런 형태의 서브 개발자?가 많이 등장할 것 같기두 하다

총평 3줄요약

1. 요즘 너무 빠르게 변화하는 IT 산업을 조금이라도 따라가게 도와준다

2. 기술적인 측면보다는 활용에 대한 소개와 전망 등 딥하지 않는 내용이니 쉽게 읽을 수 있따

3. 결론은 gpt야 고맙다

'Book' 카테고리의 다른 글

| [서평] 만만한 자소서(취업왕 이쌤 저/한빛미디어) (2) | 2025.04.08 |

|---|---|

| [서평] 파이썬으로 웹 크롤러 만들기(라이언 미첼 저/최경현 역/한빛미디어) (0) | 2025.03.24 |

| [서평] 로우코드 AI(궨덜린 스트리플링, 마이클 아벨 저/박찬성 역/한빛미디어) (0) | 2025.02.27 |

| [서평] 혼자 공부하는 얄팍한 코딩 지식(고현민 저/한빛미디어) (1) | 2024.07.26 |

| [서평] 하루 3분, 세상에서 가장 쉬운 IT 수업(장종원 저/루비페이퍼) (2) | 2024.03.01 |